Såkalla deepfakes, falske videoar, er ikkje berre ei underhaldande teknologisk nyvinning. Det kan òg vere ein trugsel for deg og bidra til konflikt mellom grupper og land.

Denne artikkelen er eldre enn 1 år gamal. Det betyr at noko av informasjonen kan vere utdatert.

Saka er ein del av NUPI Skole sin serie Hvor hender det? og er gjengjeven med løyve.

Kva ville du gjort om du såg ein video på internett av Noregs statsminister som sa at atomvåpen var planlagd brukt mot Noreg i nærmaste framtid og at alle måtte samle seg i sitt nærmaste bomberom?

For dei fleste er ein slik uttale urealistisk med bakgrunnen i den noverande sikkerheitspolitiske situasjonen. Men slike utspel treng ikkje å skje på ekte lenger for at vi skal sjå ein slik video.

Utviklinga i samfunnet går raskare enn aldri før – men for dei fleste av oss er det vanskeleg å forstå kva slags konsekvensar dette kan ha for oss i kvardagen.

Teknologien gir mange moglegheiter, men òg nye typar utfordringar. Den kan blant anna mogleggjere situasjonar som aldri hadde skjedd elles.

- Visste du at 2020 var det tristaste året på lang tid? Det har lukkemålaren slått fast!

Kva er deepfakes?

Det som mogleggjer slike hendingar som nemnd ovanfor blir kalla for deepfakes, og nyttar kunstig intelligens for å produsere videoar, lyd og bilete som kan vere vanskeleg å avsløre som falske.

Ordet deepfake kjem frå den underliggande teknologien deep learning, eller djup læring, som er ein type kunstig intelligens. Algoritmar innanfor djup læring lærer seg sjølve korleis ein løyser problema når dei får store mengder med data, og er brukt blant anna for å bytte ansikt i video som ser realistisk ut.

Maskinlæringsteknikkar har automatisert det som vanlegvis pleidde å vere ein manuell prosess, noko som gjer at det å redigere videoar på denne måten går mykje raskare.

Det er fleire måtar å lage deepfakes på, men den vanlegaste bruker djupe nevrale nettverk som involverer autokodarar som nyttar ein teknikk for bytte av ansikt. Ein trenger først ein grunnvideo som grunnlag for deepfake – og deretter ei samling videoklipp av personen du ynskjer å sette inn i denne.

Men dette er ikkje berre avgrensa til videoar. Ein kan og lage falske lydklipp.

Du er kanskje ein av mange som såg deepfake-videoen av Tom Cruise? Bakgrunnen for at det foreløpig berre er truverdige deepfakes av kjendisar og politikarar, er fordi det eksisterer så mykje data av dei på internett som kan «trene opp» maskinene til å kjenne att og attskape ansiktstrekk og stemmer.

På same tid lever dei aller fleste av oss store deler av liva våre digitalt – og denne dataen som vi deler med omverda, kan fort påverke oss på måtar vi ikkje hadde sett føre oss tidlegare.

Enkeltpersonar kan bli utsett for utpressing, men følgene kan òg vere av eit helt anna kaliber.

@deeptomcruiseI love magic!

Store internasjonale konsekvensar

Deepfakes kan òg vere retta mot land og ha politiske motiv. No er det kanskje ikkje Noreg som er det største målet for deepfakes som spesifikt rettar seg mot statar. Men vi som eit lite land i ei stor samankopla verd, kan bli påverka av dei tilhøyrande konsekvensane.

Måla kan vere land som har skjøre institusjonar, innbyggjarar med låg digital kompetanse, på same tid som dei har ei splitta befolkning.

Det er mange tenkte situasjonar som kunne hatt store internasjonale konsekvensar.

Dersom Donald Trump, tidlegare president i USA, i ein video under sin presidentperiode hadde spotta prestestyret i Iran, håna deira religion – eller latterleggjort andre regime USA har eit anstrengt forhold til, kunne konsekvensane vore store og skjebnesvangre. Sjølv om dette raskt ville blitt avslørt som falsk, ville videoen og bodskapen allereie ha spreidd seg breitt.

Teknologien bak deepfakes vil òg etter kvart vere særs freistande for fleire statar å bruke for å manipulere både eigne innbyggjarar, men òg innbyggjarar i andre land. Ved å bruke slike videoar rett før eit val kan ein òg bidra til å snu opinionen på kort tid.

Deepfakes har rett og slett sprengkrafta til å sørge for politisk motivert vald, sabotere val – og øydelegge diplomatiske relasjonar.

Scenarioa er kanskje ikkje sannsynleg med det første, men ulempa er at det er så mange aktuelle scenario at det ikkje er overraskande om noko liknande vil kunne skje i framtida.

Etter kvart som teknologien utviklar seg og spreier seg over heile verda, vil òg mange av oss ha moglegheita til å lage videoar og lydklipp som kan overtyde dei fleste. Snart vil det krevjast eksterne verktøy for å kunne skilje dei manipulerte frå dei ekte videoane.

- Les også om lærardilemmaet: Å vise eller å ikkje vise Muhammed-karikaturane

Berre starten på «fake news»

I over hundre år har video og lyd fungert som ei slags kvalitetssikring av kva som er sant og ikkje. Allereie er det nokre som stiller spørsmål kring hendingar som vi har tydelege bevis for skjedde, som Holocaust, 9/11 og månelandinga.

Om deepfakes gjer at tilliten til desse bevisa blir enno svakare, kan ein risikere at utfordringane ein ser no knytt til konspirasjonsteoriar og desinformasjon berre vil forverre seg.

Deepfakes er ein tilhøyrande del til eit større problem som i stor grad er skapt med massiv informasjonsflyt igjennom internett og sosiale medium, som diverre ofte blir utnytta. Internett som domene har aldri hatt ein god måte på å skille mellom kva som er ekte og kva som er falskt. Når ein ser på eit bilete på ein skjerm er det vanskeleg å avgjere kva som er ekte og ikkje.

Når ein ser på eit bilete på ein skjerm er det vanskeleg å avgjere kva som er ekte og ikkje.

Manipuleringar er ikkje noko nytt, ei heller med politisk motiv. Sovjetunionen under Stalin fjerna sine meiningsmotstandarar og andre frå bileta for å skrive om på historia. Framveksten av deepfakes er eit vendepunkt i moglegheita til å skape falskt innhald. På same tid er det falske innhaldet stadig vanskelegare å oppdage – og raskare å lage.

Dei amerikanske professorane Robert Chesney og Danielle Citron har vist til ein effekt der dei vanlege innbyggjarane blir meir merksame på deepfakes. Dette kan sørge for at stadig fleire vil så tvil om kor ekte alle slags videoar er.

Vidare kan det difor skape mogelegheiter for nokon som blir tatt for dårleg oppførsel i ein ekte video. Det vil vere enklare å avvise videoar som faktisk er autentiske som falske og deepfake.

Kva kan gjerast?

Vi ser allereie konsekvensane av sosiale medium – og bruken av desinformasjon både oppimot val, men òg i andre samanhengar. Det svekker vanlege folk si evne til å henge med på den politiske utviklinga – og det kan utvikle seg til å bli eit demokratisk problem.

Vi veit at vi allereie blir sterkt påverka av algoritmar i måten vi finn informasjon på internett på, og det blir endå meir forsterka med deepfakes.

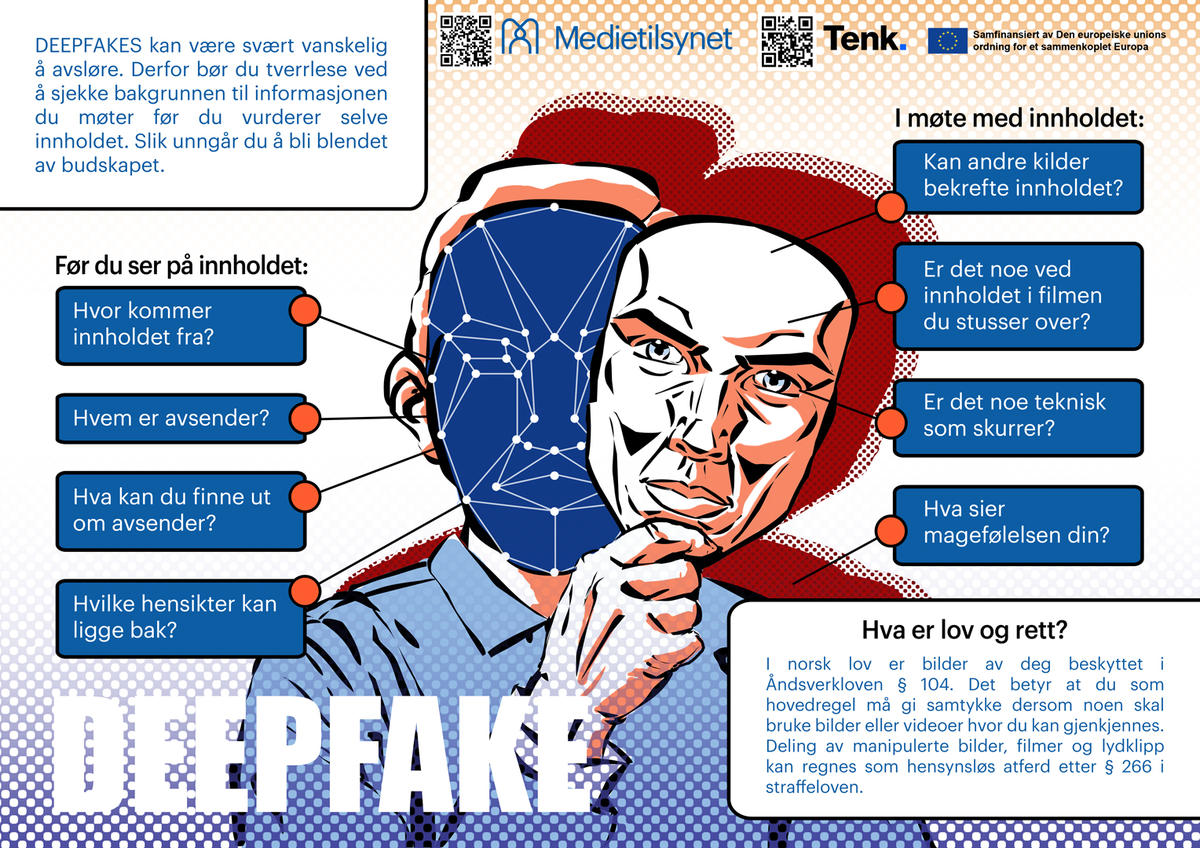

Medietilsynet har forma eit eige undervisningsopplegg om deepfakes, som skal fremje kritisk medieforståing. Plakat: Medietilsynet

Kva kan ein gjere når ein verken kan stole på det ein les, ser eller høyrer?

Statar på tvers av landegrenser har alt tatt til orde for å igangsette initiativ for å legge press på store selskap som styrer mykje av informasjonsflyten i dagens samfunn. FN skal kanskje òg ha ei rolle i dette ved å sørge for internasjonalt regelverk på tvers av medlemslanda.

Heldigvis er fleire av dei store selskapa i ferd med å ta dette meir på alvor. Blant anna har Facebook skissert kvalitetssikrande tiltak for å skille ut deepfakes som er meint å lure sine brukarar – og mange selskap har alt tatt i bruk verktøy for å kunne handtere utviklinga.

Kjeldekritikk er eit nøkkelord for korleis vi kan avgrense konsekvensane deepfakes kan få. Ein av måtane er aktiv bevisstgjering – og igjennom bruken av populærkultur for å tydeleggjere kva utfordring dette representerer.

Kjeldekritikk er eit nøkkelord for korleis vi kan avgrense konsekvensane deepfakes kan få. Ein av måtane er aktiv bevisstgjering – og igjennom bruken av populærkultur for å tydeleggjere kva utfordring dette representerer.

South Park-skaparane har blant anna laga miniserien Sassy Justice, som brukar deepfake-teknologi for å sette inn kjendisar og politikarar i ei fiktiv verd til ein TV-reportar. Denne serien kan bidra til at fleire forstår omfanget og konsekvensane av tidsalderen vi lever i.

Vi veit allereie kor mykje feilinformasjon som blir formidla i sosiale medium, og deepfakes kan bidra til å forsterke ein allereie faretruande trend.

Sabah Jassim, professor ved Universitetet i Buckingham, påpeiker i eit intervju at analysar av deepfake-videoar viser at per no er det mindre blinking i falske videoar, lyden kan passe dårleg med bevegelsane i leppene og ofte verker det som at det er krevjande å gi uttrykk for kjensler.

Foreløpig er det mogleg å skille dei falske frå dei ekte videoane, men etter kvart som mekanismar for å skille ut falske videoar utviklar seg, er det naturleg å tru at kvaliteten på deepfakes blir endå betre.

Det vil mest sannsynleg bli ein varig kamp, der kunstig intelligens må trenast jamleg for å kunne vere i forkant.

- Les også om korleis arbeidskvardagen er som etisk hackar! – Når ordet kjem opp vert folk automatisk redd for at eg skal hacke Facebooken deira! Det er overhovudet ikkje det vi driv med, fortel Mia Landsem